こんにちは。SCSKの松渕です。

今年もGoogle Cloudの祭典、年次イベントである「Google Cloud Next Tokyo ’25」が、東京ビックサイトで開催されました!

この記事では数多くの発表の中から、エージェント型AI時代における運用にフォーカスした2セッションを、2回にわたりレポート形式でまとめます!

※弊社も登壇やブース出しておりましたが本レポートでは触れません。

Google Cloud Next Tokyo ’25とは

世界中で開催されるGoogle Cloud Nextの中でも、日本の技術者やビジネスパーソンにとって最も重要なイベントの一つです。

最新のAIやデータ分析、クラウドインフラに関する発表はもちろん、日本のビジネスシーンに特化したセッションや事例も豊富に用意されていました。

今年は2025年8月5日(火)と8月6日(水) の二日間にわたって開催されました。

イベントレポート

セッション1:最新の生成 AI モデルへのアップデートに必要な LLMOps

発表者:GoogleCloud社

LLMOpsとは

LLMOps(Large Language Model Operations)とは、大規模言語モデル(LLM)を効率的かつ継続的に開発、デプロイ、運用、管理するための手法やプロセスの総称です。

DevOps(開発と運用の連携)や、機械学習モデルの運用に特化したMLOps(Machine Learning Operations)の概念を、LLM特有の課題に合わせて拡張したものです。

セッション内容

では、セッションの中身に入ります!

生成AIのサポート期限について

最初に問いかけから始まります。皆さんは自身の利用している生成AIのモデルがいつまで使えるかご存知ですか?

私は恥ずかしながら知りませんでした。

基本的に1年でサポート切れます

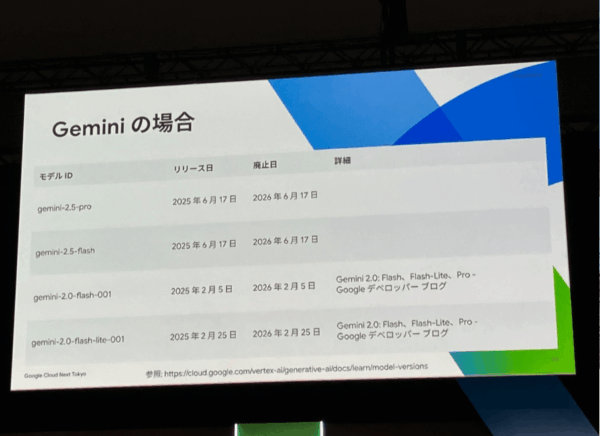

Geminiは基本的にリリースから1年でサポート切れるとのこと。

ちなみに、claudeもリリースから1年が基本的なサポート期間のようです。

AzureからのAPIによるGPT利用についてもリリースから1年がサポート期間のようです。

モニタリングする観点

PoCで精度を確認してリリースしても、適切なモニタリングをしていない場合、

運用時にモデル精度が下がるリスク(結果としてユーザが離脱するリスク)があります。

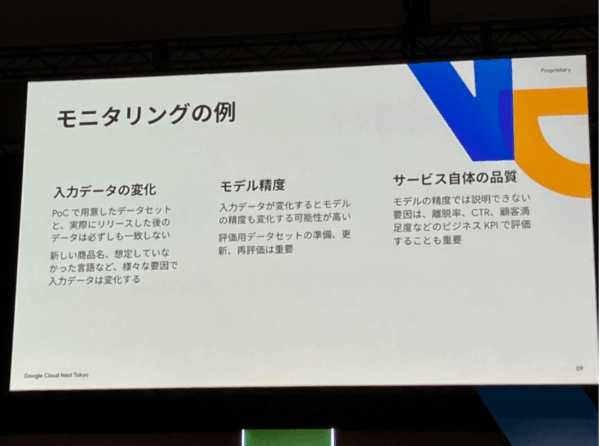

そのため、モニタリングが必要となるのですが、大きく以下のような項目(観点)でモニタリングするとの説明でした。

- 入力データの変化:

新しい表品名等、学習時と入力データの時間経過のモニタリング。

時間によって変わる単語の意味が変わることも含まれます。(わかりやすいところで若者言葉、はやり言葉など) - モデル精度:

一番直接的なモニタリングですね。

入力データの変化に伴い、評価用データセットも初期構築時のものから更新が必要になります。

ここでいう「モデル」は何を指すかが難しいと感じたのですが、

私は「利用するLLM(バージョン含む)+プロンプト」の組み合わせと理解をしました。 - サービス自体の品質:

モデル精度低下によって影響が出ると予想されるビジネスKPIの評価を指します。

LLMOpsのステップ

具体的にLLMOpsをどのように実施するかの話に入ります。

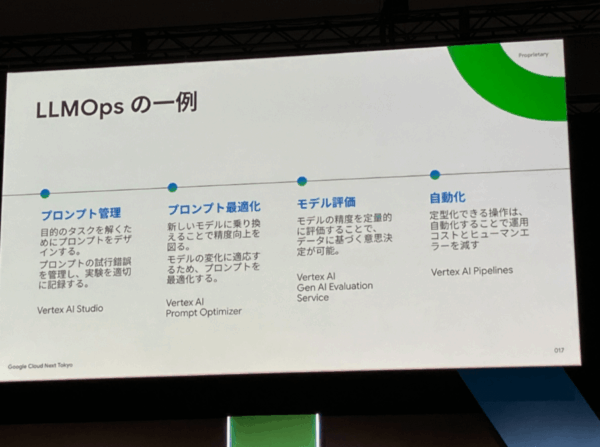

4つのステップに分けて説明されていました。

- プロンプト管理

一番イメージしやすいところかと思います。

プロンプトをしっかり管理します。プログラム管理のイメージに近いかと思います。 - プロンプト最適化

最初のスライドにあった、LLMのサポート切れにもつながる点ですね。

LLMのバージョンアップに伴うプロンプトの最適化作業等が該当します。

また、入力データの時間変化に伴うプロンプトの修正も含まれます。 - モデル評価

プロンプト最適化の後は再度評価が必要になります。 - 自動化

LLMOpsに限らずですが、定型化作業は可能ならば自動化することで効率化及びエラー防止に役立ちます。

LLMOps利用できるGoogle Cloudのサービス ~プロンプト管理~

ここからはGoogle Cloudの話に入っていきます。

Google CloudのサービスでLLMOpsに有用なサービスの紹介をしていきます。

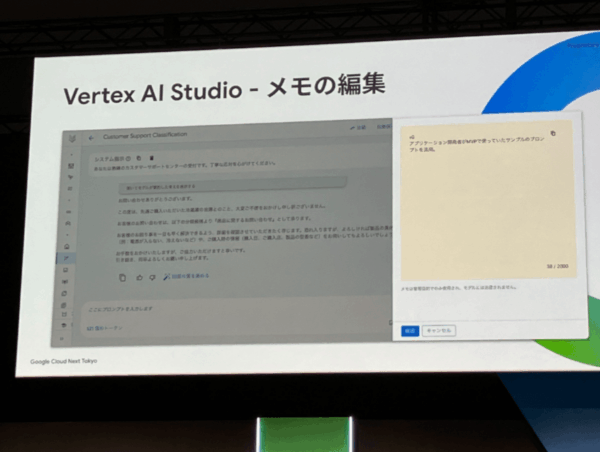

AI開発にはVertex AI Studio使うと思いますが、メモ機能があります。

プロンプト作る際に考えたことや検討事項を残すことで、保守性が向上します。

他にも修正履歴の一覧化や、バージョン間のプロンプトが左右表示で見やすく比較できる画面などLLM管理に有用な機能が紹介されました。

LLMOps利用できるGoogle Cloudのサービス ~プロンプト最適化~

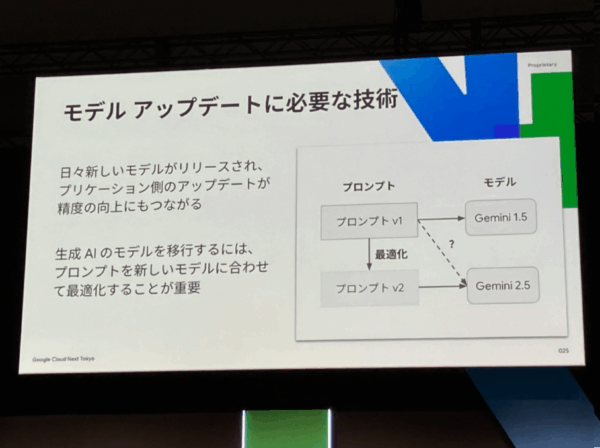

次に紹介されたのがPrompt Optimizerです。

私自身経験ありますが、同一プロンプトでモデルバージョンアップすると、精度が落ちるケースがあります。

スライドの通りGemini1.5から2.5にバージョンアップしたケースでした。

そのような、モデルバージョンアップ時のプロンプト最適化を支援してくれるサービスです。

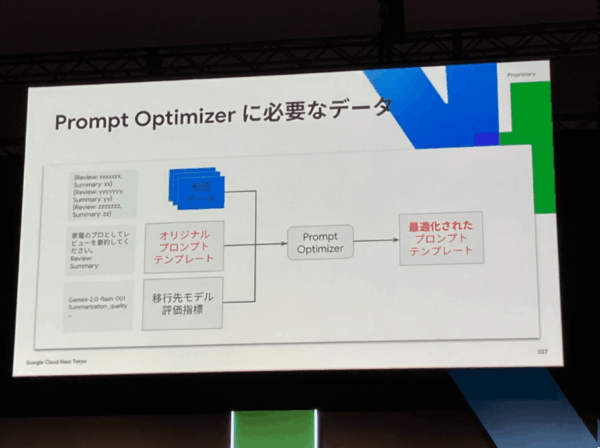

元のLLMと、評価データ、評価指標を与えることで最適化されたプロンプトが出来上がるとのこと。

ぜひ試してみたい!!

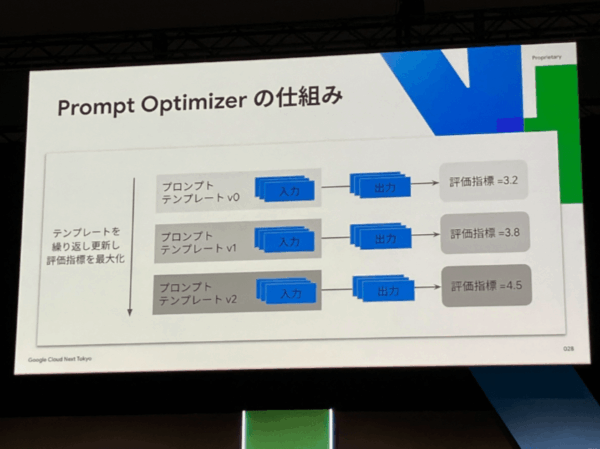

内部動作としては、複数のプロンプトを作っては評価して、評価指標を少しづつ上げていくような動きをするようです。

LLMOps利用できるGoogle Cloudのサービス ~モデル評価~

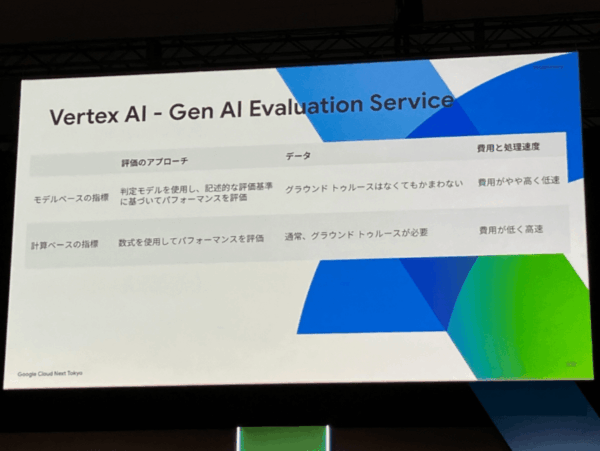

モデル評価については、モデルベースの指標と計算ベースの指標があります。

ユースケースに応じて使い分けましょう。

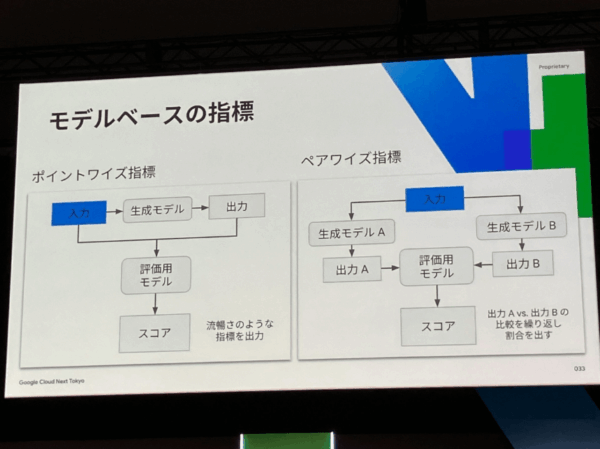

- モデルベース指標

いわゆるLLM-as-a-judgeと呼ばれる手法ですね。

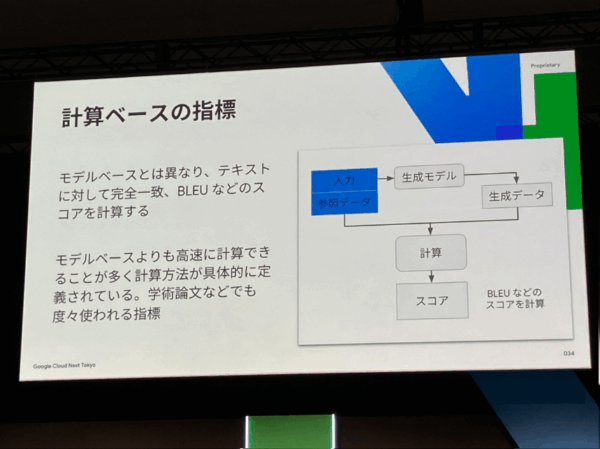

評価用のモデル(プロンプト)を用意して評価させる方法です。 - 計算ベースの指標

正解データとの文字の完全一致割合や、重要な単語がどれだけ共通して出てきているか等の指標に基づいて、

機械的に計算できるロジックで評価する手法です。

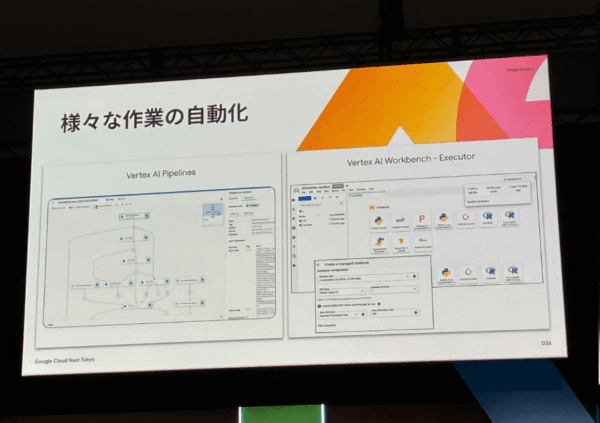

LLMOps利用できるGoogle Cloudのサービス ~自動化~

最後に自動化についてでは、Vertex AI Pipline、Vertex AI Workbench – Executorといった自動化サービスが紹介されました。

セッションの感想

サポート期限の短さやデータの時間的な変化に伴う精度低下等、生成AI案件特有の運用課題というのが少しづつ浸透してきているのが現状かなと思っております。

LLMOpsをしっかり学び、プロンプトの管理と継続的な評価をしっかり行い、常に最適な状態でLLMを運用することが今後数年で重要になってくると感じました。

次回

次回は「AIオブザーバビリティ」について投稿しようと思います!